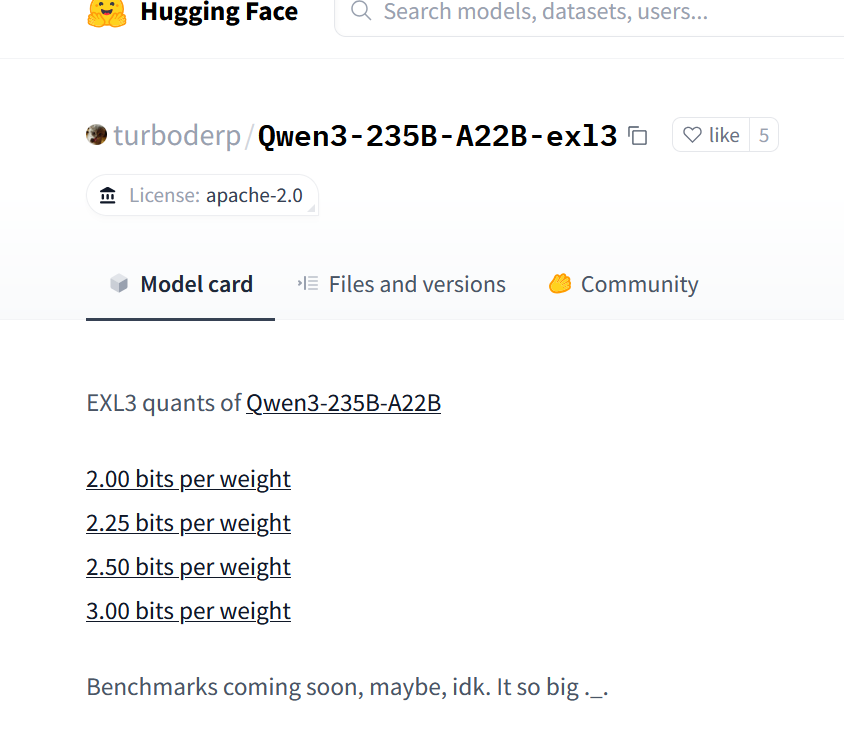

Локальные языковые модели (LLM): LLaMA, Gemma, DeepSeek и прочие №140 /llama/

Аноним

18/06/25 Срд 00:45:41

№

1